一、前言

ELK是三个开源软件的缩写,分别表示:Elasticsearch , Logstash, Kibana , 它们都是开源软件。新增了一个FileBeat,它是一个轻量级的日志收集处理工具(Agent),Filebeat占用资源少,适合于在各个服务器上搜集日志后传输给Logstash,官方也推荐此工具。

- Elasticsearch是个开源分布式搜索引擎,提供搜集、分析、存储数据三大功能。它的特点有:分布式,零配置,自动发现,索引自动分片,索引副本机制,restful风格接口,多数据源,自动搜索负载等。

- Logstash 主要是用来日志的搜集、分析、过滤日志的工具,支持大量的数据获取方式。一般工作方式为c/s架构,client端安装在需要收集日志的主机上,server端负责将收到的各节点日志进行过滤、修改等操作在一并发往elasticsearch上去。

- Kibana 也是一个开源和免费的工具,Kibana可以为 Logstash 和 ElasticSearch 提供的日志分析友好的 Web 界面,可以帮助汇总、分析和搜索重要数据日志。

二、安装elk

这里为了快速安装,此处采用docker快速安装。

1、配置与安装

echo "vm.max_map_count=262144" > /etc/sysctl.conf

sysctl -p

docker run -dit --name elk \

-p 5601:5601 \

-p 9200:9200 \

-p 5044:5044 \

-v /opt/elk-data:/var/lib/elasticsearch \

-v /etc/localtime:/etc/localtime \

sebp/elk:740

注:-p 指定映射端口,5601kibana访问,9200es端口,5044 logstash收集日志端口;-v 指定es数据目录。

2. 配置ELK(以下内容全部在容器内操作)

1)进入docker容器

[root@localhost /]# docker exec -it elk /bin/bash

/etc/logstash/ ## logstash 配置文件路径

/etc/elasticsearch/ ## es 配置文件路径

/var/log/ ## 日志路径

2)配置Logstash

vim /etc/logstash/conf.d/02-beats-input.conf

# 数据输入配置:port -> 端口号;codec -> 输入格式。这里以logback为例。

input {

tcp {

port => 5044

codec=>json_lines

}

}

# 数据输出配置:hosts -> 主机集合;index -> 你将要创建的索引名称。这里es为例。

output {

elasticsearch {

hosts => ["127.0.0.1:9200"]

index => "%{[appName]}-%{+YYYY.MM.dd}"

}

}

注:这个配置文件可以在/etc/logstash/conf.d/目录下创建,也可直接修改原有配置文件,看个人需求。

3)配置kibana中文

vim /opt/kibana/config/kibana.yml

注:打开文件后,在文件内追加 i18n.locale: "zh-CN" ,重启服务即可。

4)常用服务操作命令

[root@localhost /]# service logstash start/restart/stop/status

[root@localhost /]# service elasticsearch start/restart/stop/status

[root@localhost /]# service kibana start/restart/stop/status

注:上面是各个服务 启动 / 重启 / 停止 / 状态,服务较大操作会比较缓慢,不要重复执行命令。

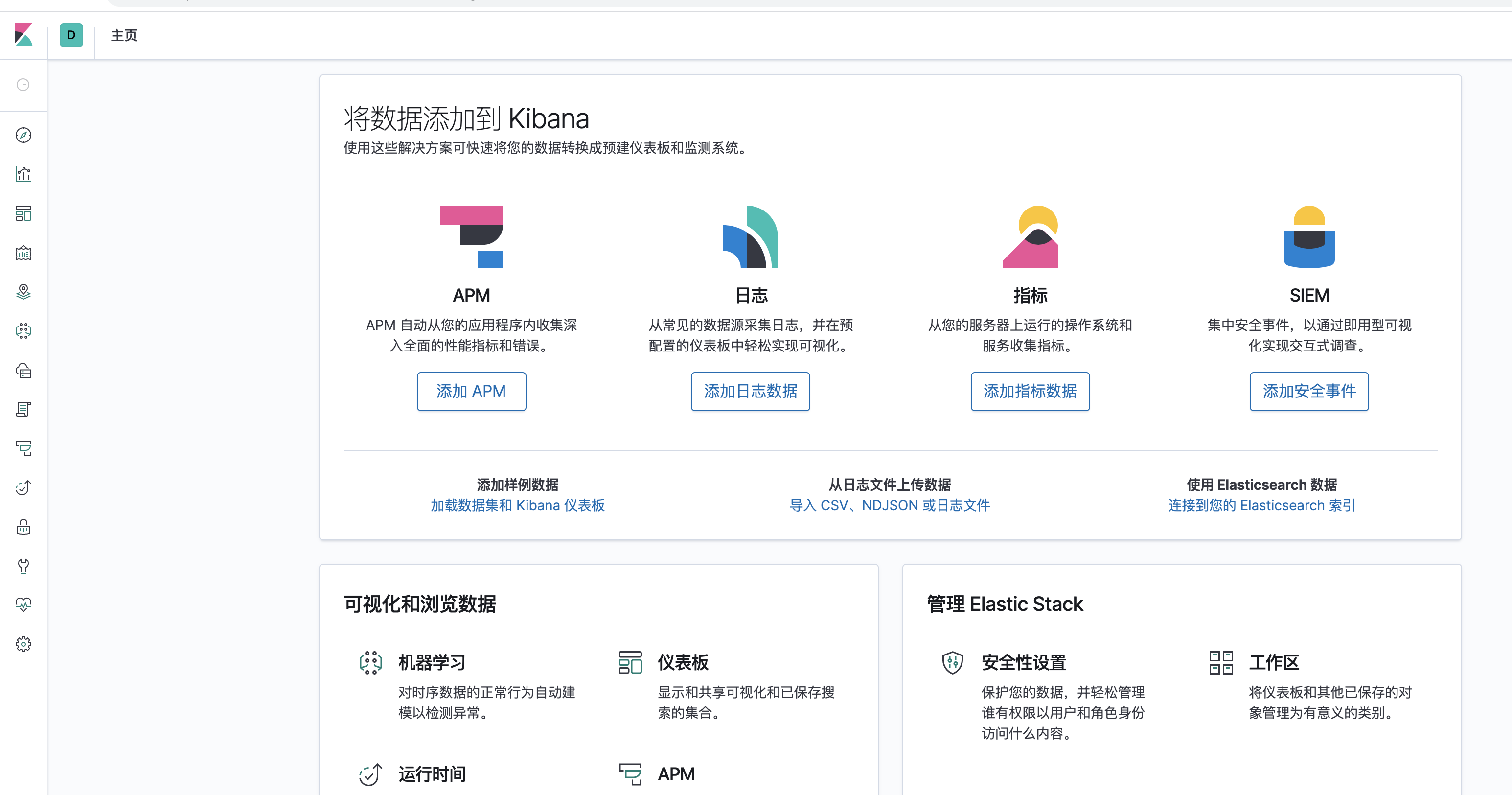

5)访问

ip:5601

三、springBoot项目配置

1)新建springBoot项目

2)加入pom

<dependency>

<groupId>net.logstash.logback</groupId>

<artifactId>logstash-logback-encoder</artifactId>

<version>5.3</version>

</dependency>

3)在resources\logback.xml增加配置文件

<?xml version="1.0" encoding="UTF-8"?>

<configuration debug="false">

<!--定义日志文件的存储地址 勿在 LogBack 的配置中使用相对路径-->

<property name="LOG_HOME" value="./logs" />

<!-- 控制台输出 -->

<appender name="STDOUT" class="ch.qos.logback.core.ConsoleAppender">

<encoder class="ch.qos.logback.classic.encoder.PatternLayoutEncoder">

<!--格式化输出:%d表示日期,%thread表示线程名,%-5level:级别从左显示5个字符宽度%msg:日志消息,%n是换行符-->

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger{50} - %msg %n</pattern>

</encoder>

</appender>

<!-- 按照每天生成日志文件 -->

<appender name="info-file" class="ch.qos.logback.core.rolling.RollingFileAppender">

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<!--日志文件输出的文件名-->

<FileNamePattern>${LOG_HOME}/runtime-info-%d{yyyy-MM-dd}.log</FileNamePattern>

<!--日志文件保留天数-->

<MaxHistory>30</MaxHistory>

</rollingPolicy>

<encoder class="ch.qos.logback.classic.encoder.PatternLayoutEncoder">

<!--格式化输出:%d表示日期,%thread表示线程名,%-5level:级别从左显示5个字符宽度%msg:日志消息,%n是换行符-->

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger{50} - %msg%n</pattern>

</encoder>

<filter class="ch.qos.logback.classic.filter.LevelFilter"><!-- 只打印WARN日志 -->

<level>INFO</level>

<onMatch>ACCEPT</onMatch>

<onMismatch>DENY</onMismatch>

</filter>

<!--日志文件最大的大小-->

<triggeringPolicy class="ch.qos.logback.core.rolling.SizeBasedTriggeringPolicy">

<MaxFileSize>10MB</MaxFileSize>

</triggeringPolicy>

</appender>

<appender name="debug-file" class="ch.qos.logback.core.rolling.RollingFileAppender">

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<!--日志文件输出的文件名-->

<FileNamePattern>${LOG_HOME}/runtime-debug-%d{yyyy-MM-dd}.log</FileNamePattern>

<!--日志文件保留天数-->

<MaxHistory>30</MaxHistory>

</rollingPolicy>

<encoder class="ch.qos.logback.classic.encoder.PatternLayoutEncoder">

<!--格式化输出:%d表示日期,%thread表示线程名,%-5level:级别从左显示5个字符宽度%msg:日志消息,%n是换行符-->

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger{50} - %msg%n</pattern>

</encoder>

<filter class="ch.qos.logback.classic.filter.LevelFilter"><!-- 只打印WARN日志 -->

<level>DEBUG</level>

<onMatch>ACCEPT</onMatch>

<onMismatch>DENY</onMismatch>

</filter>

<!--日志文件最大的大小-->

<triggeringPolicy class="ch.qos.logback.core.rolling.SizeBasedTriggeringPolicy">

<MaxFileSize>10MB</MaxFileSize>

</triggeringPolicy>

</appender>

<appender name="error-file" class="ch.qos.logback.core.rolling.RollingFileAppender">

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<!--日志文件输出的文件名-->

<FileNamePattern>${LOG_HOME}/runtime-error-%d{yyyy-MM-dd}.log</FileNamePattern>

<!--日志文件保留天数-->

<MaxHistory>30</MaxHistory>

</rollingPolicy>

<encoder class="ch.qos.logback.classic.encoder.PatternLayoutEncoder">

<!--格式化输出:%d表示日期,%thread表示线程名,%-5level:级别从左显示5个字符宽度%msg:日志消息,%n是换行符-->

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger{50} - %msg%n</pattern>

</encoder>

<filter class="ch.qos.logback.classic.filter.LevelFilter"><!-- 只打印WARN日志 -->

<level>ERROR</level>

<onMatch>ACCEPT</onMatch>

<onMismatch>DENY</onMismatch>

</filter>

<!--日志文件最大的大小-->

<triggeringPolicy class="ch.qos.logback.core.rolling.SizeBasedTriggeringPolicy">

<MaxFileSize>10MB</MaxFileSize>

</triggeringPolicy>

</appender>

<appender name="logstash" class="net.logstash.logback.appender.LogstashTcpSocketAppender">

<param name="Encoding" value="UTF-8"/>

<destination>ip:5044</destination>

<encoder charset="UTF-8" class="net.logstash.logback.encoder.LogstashEncoder" >

<customFields>{"appName":"test"}</customFields>

</encoder>

</appender>

<!-- 日志输出级别 -->

<root level="INFO">

<appender-ref ref="STDOUT" />

<appender-ref ref="info-file" />

<appender-ref ref="debug-file" />

<appender-ref ref="error-file" />

<appender-ref ref="logstash" />

</root>

</configuration>

注:这里的ip是logstash的服务的ip。

4)编写测试代码

@RestController

public class UserController {

private static Logger log = LoggerFactory.getLogger(UserController.class);

@GetMapping("/hello")

public String hello() {

log.info("ELK测试日志");

log.info("测试");

return "test.com";

}

@GetMapping("/test")

public String test() {

int a=1/0;

return "test.com";

}

}

5)启动项目

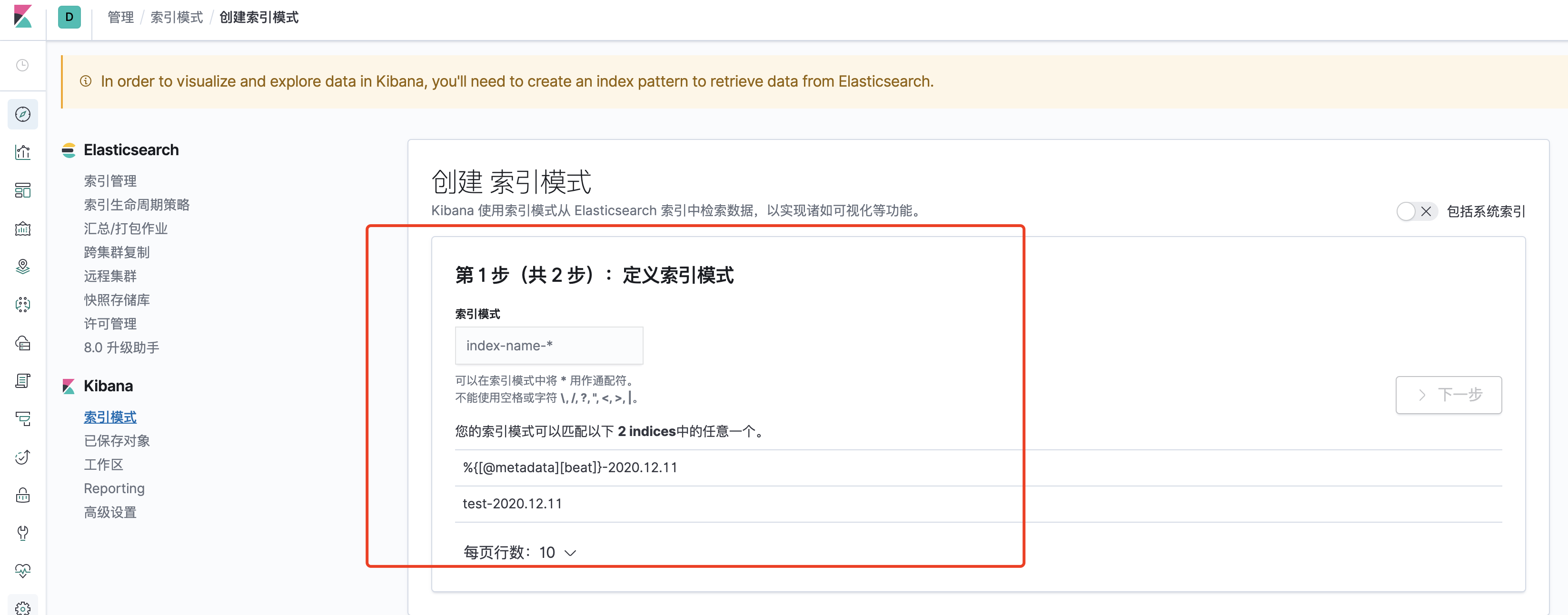

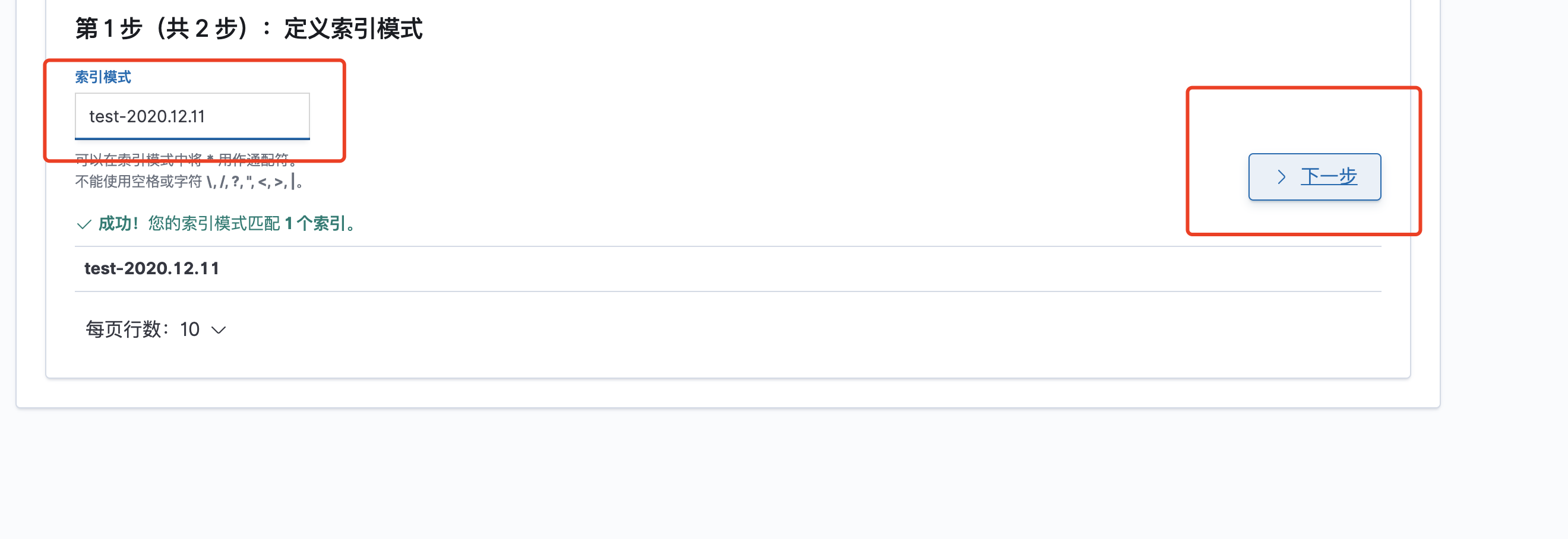

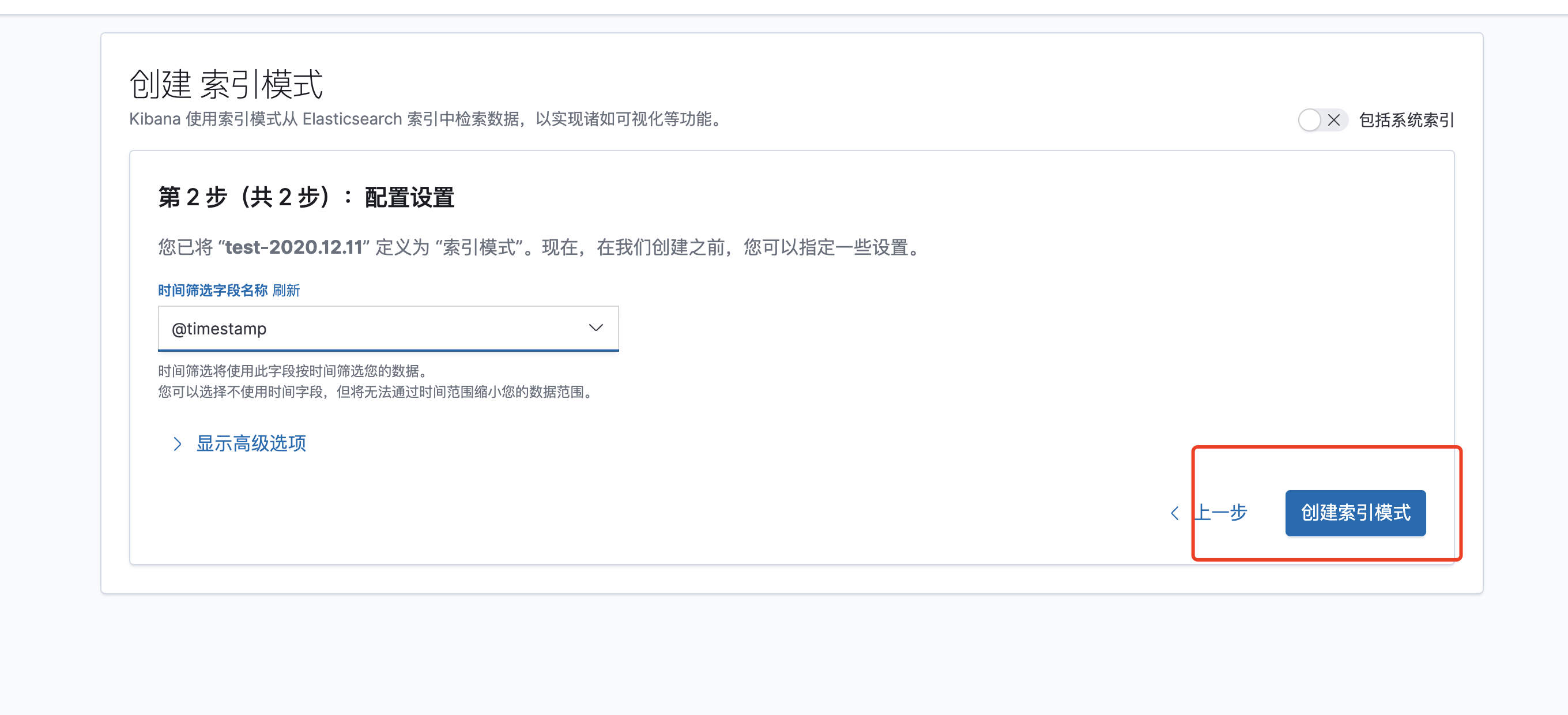

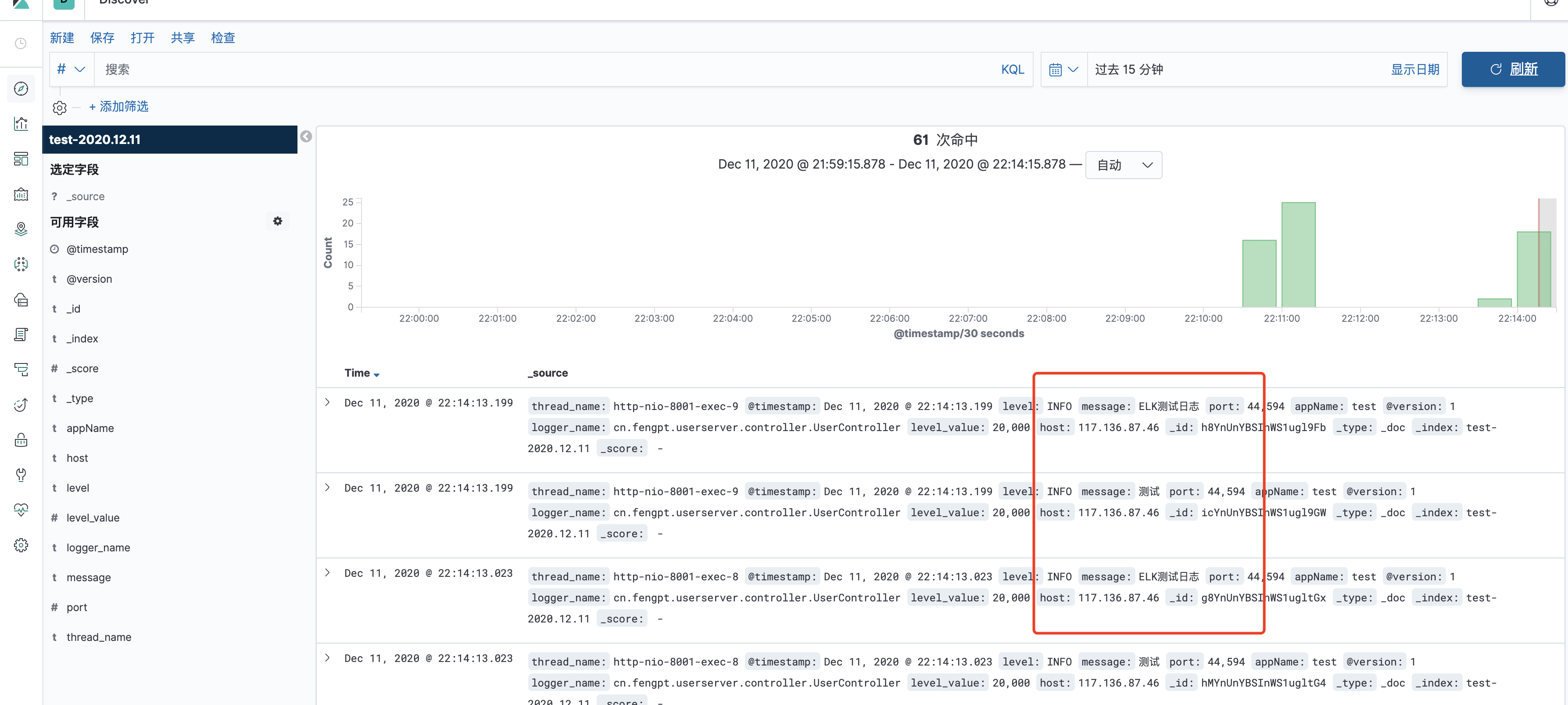

6)在kibana配置

- 访问接口:/hello

即可在kibana查看到日志:

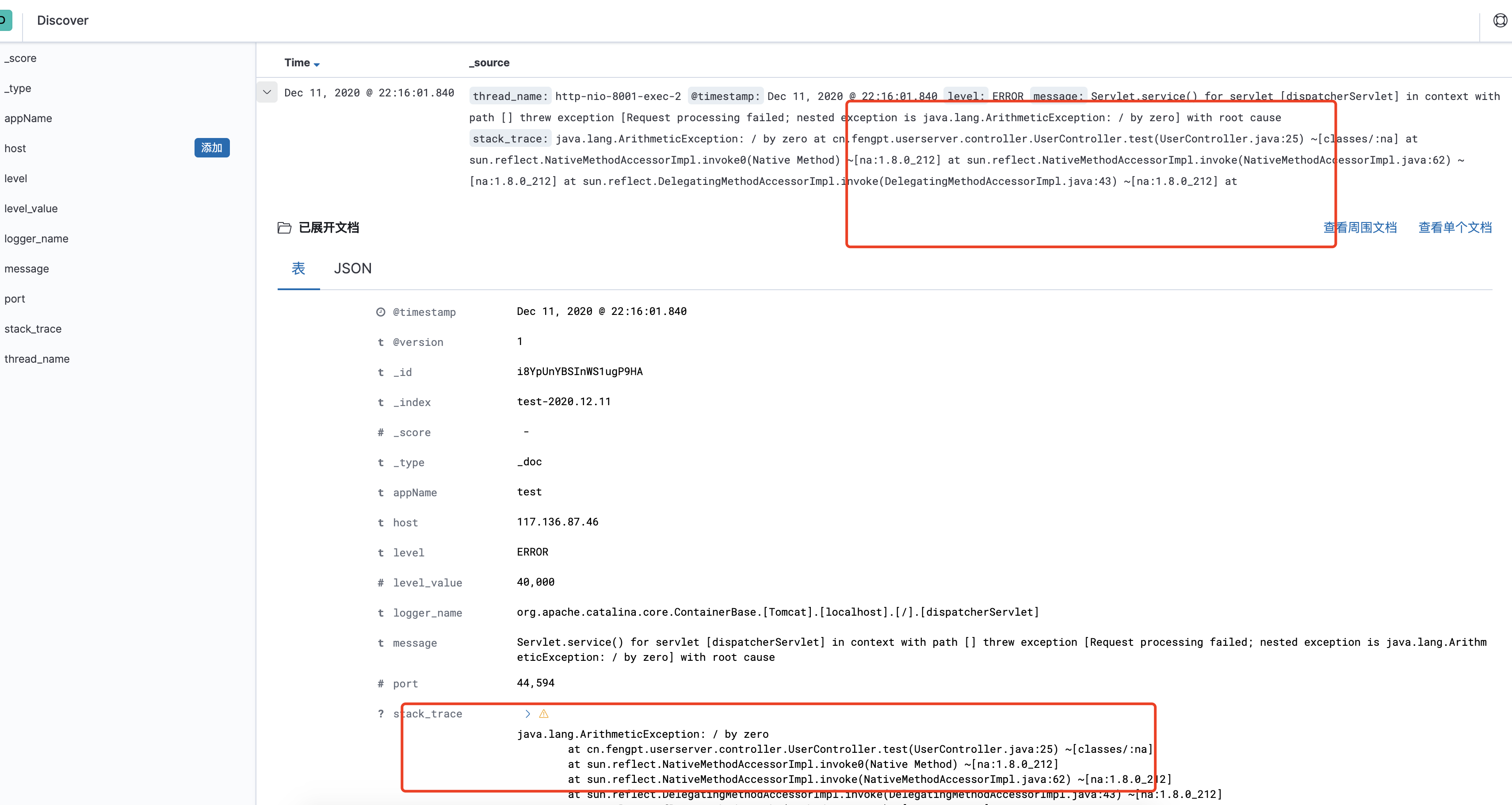

- 访问接口:/test

可查看到错误日志:

评论区